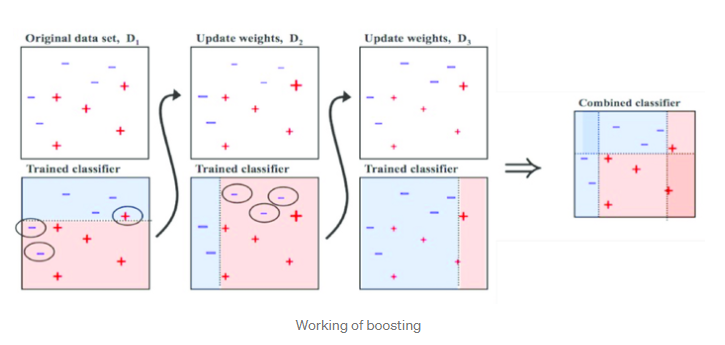

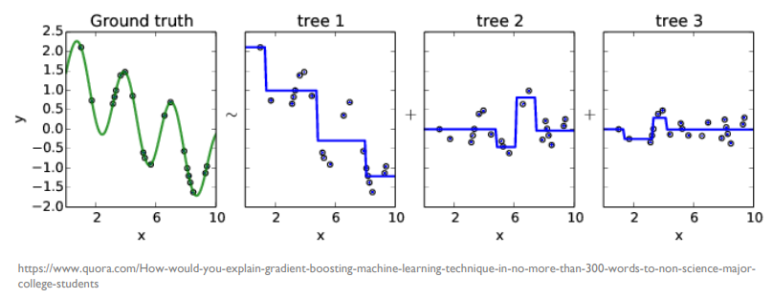

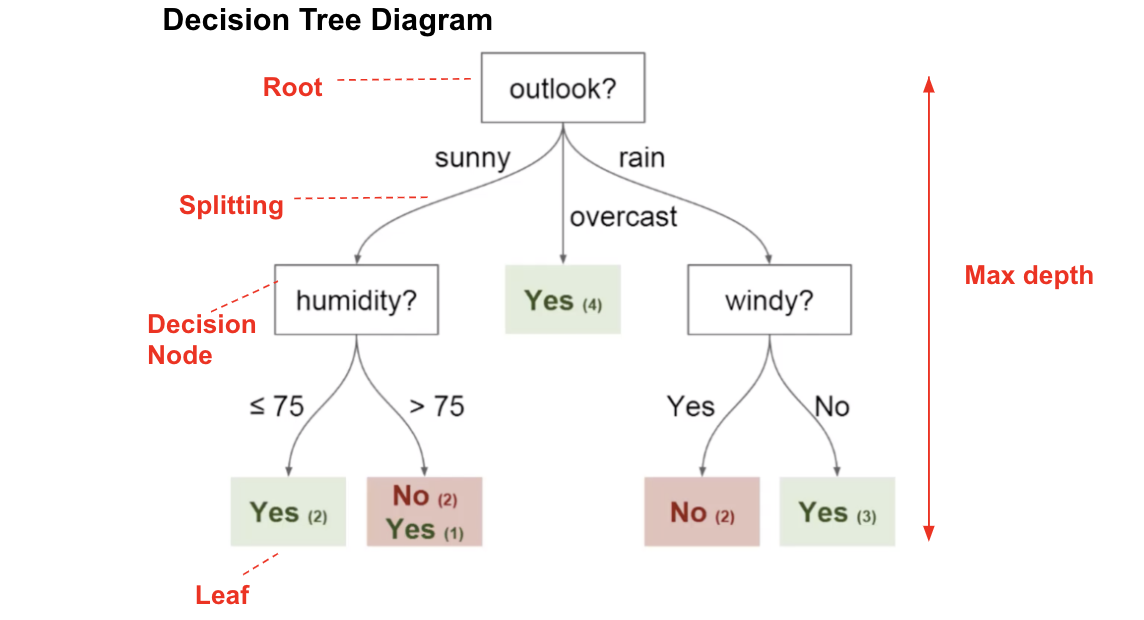

목차 1. 소개 2. XGBOOST 흐름 3. 논문속 수식으로 이해 4. 참고자료 1 . 소개 앙상블(ensemble) 방법이란 티끌 모아 태산이라는 아이디어를 담고있다. 성능이 좋지 않은 분류기를 여러개 모아서 합치면 좋은 성능을 낸다는 것이다. 자세히 말하면, 분류기 하나(A Decision Tree)는 특정 몇개의 특성에 대해서 판단할 수 있지만, 분류기 여러개(Decision Trees)를 사용해 나온 결과를 종합해서 최종 결과를 낸다면 => 모든 분류기에서 사용된 특성 판단 조건들(Decision Nodes)을 모두 어느 정도 사용을 할 수 있어서 => 차원 높은 분류가 가능해진다. 이런 앙상블 방법에는 1. Bagging 2. Boosting 등이 있다. 1. Bagging (boo..