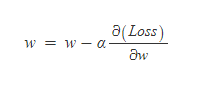

PyTorch가 dynamic auto differentiation(autodif)를 지원한다고 하기에 이 Auto differentiation이 무엇인지 한번 알아보려고 한다. 우리는 Gradient Descent를 이용해 손실함수의 최솟값을 쫓아가면서 가중치들을 업데이트한다. 이때, 가중치를 업데이트 하는 방법은 아래와 같다. 현재 가중치에 Loss를 현재 업데이트하려는 가중치로 편미분한값을 스케일조정(a)해서 빼주는 방식으로 업데이트 한다. Gradient Descent에 대해서는 잘 설명된 글이 넘쳐나기 때문에 이 정도에서 마무리하고 이때, 저 미분값을 컴퓨터가 어떻게 계산할 것인지에 대해 다뤄보고자 한다. Finite Differencing 가장 먼저, 도함수의 정의를 이용..