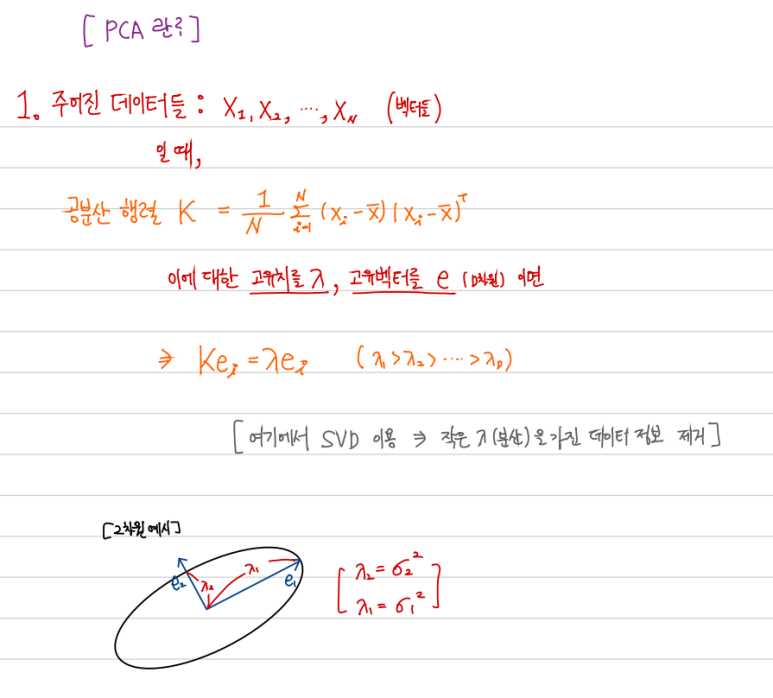

PCA의 목적함수는 결론부터 말하자면 차원축소를 위해 제거한 고유치(λ)들의 합이다. 이를 증명해보자. PCA부터 review 하자 더 자세한 내용은 내 블로그 다음 글 참조 https://nlp-study.tistory.com/24 [4-2] PCA(주성분 분석)와 SVD(특이값 분해) 차원축소를 완벽하게 이해하기 오늘은 정말 중요한 PCA와 SVD (특이값 분해)차원축소에 대해 다룰 것이다. 선형대수학을 배웠으면 천천히 따라가면서 충분히 이해 할 수 있을 것이다. 부디 이를 정확이 이해하고 싶다면 자신만 nlp-study.tistory.com 1. 표준화 표준화를 먼저 해준다. 이는 정보의 왜곡을 방지하고, 계산을 단순화 시킨다. 2. 근사 차원 축소를 통해 정제된 데이터를 가지고, 원래 값을..